12 de ago 2025

Estudo revela que raciocínio das IAs é apenas uma ilusão temporária

Modelos de inteligência artificial falham em lógica genuína, levantando preocupações sobre sua eficácia em setores críticos como medicina e finanças

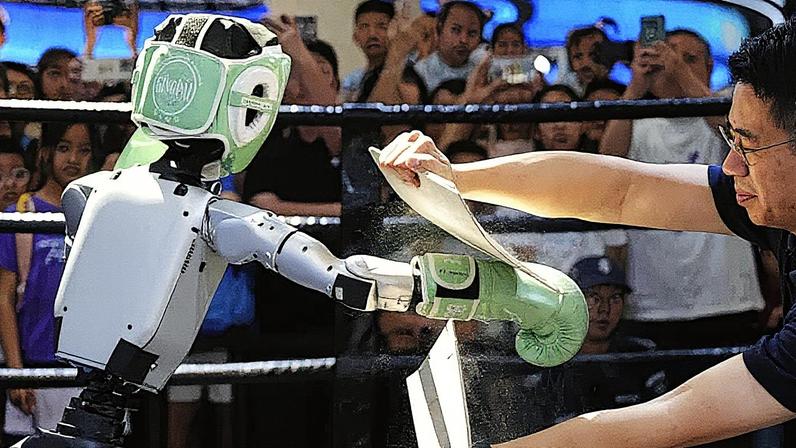

Por meio do processo chamado "cadeia de pensamento" (CoT, na sigla em inglês), IAs buscam resolver problemas complexos em múltiplos passos lógicos (Foto: zf L/Getty Images)

Ouvir a notícia:

Estudo revela que raciocínio das IAs é apenas uma ilusão temporária

Ouvir a notícia

Estudo revela que raciocínio das IAs é apenas uma ilusão temporária - Estudo revela que raciocínio das IAs é apenas uma ilusão temporária

Nos últimos anos, a indústria de inteligência artificial tem se concentrado no desenvolvimento de modelos que imitam o raciocínio humano, especialmente através da técnica conhecida como cadeia de pensamento (CoT). Recentemente, uma pesquisa da Universidade do Arizona trouxe à tona falhas significativas desses modelos, revelando que eles frequentemente não compreendem a lógica de forma genuína.

O estudo indicou que os sistemas de CoT, utilizados por empresas como OpenAI e Google DeepMind, muitas vezes produzem respostas incoerentes quando desafiados fora do escopo de seus dados de treinamento. Os pesquisadores observaram que, ao serem apresentados a questões que desviam ligeiramente dos padrões comuns, esses modelos falham em oferecer respostas lógicas.

Limitações dos Modelos

Para investigar as capacidades de raciocínio dos modelos, os cientistas criaram um ambiente controlado chamado DataAlchemy. Nesse sistema, pequenos modelos foram treinados com transformações textuais simples e, em seguida, desafiados a resolver problemas que não correspondiam exatamente ao que haviam aprendido. Os resultados mostraram que, quando solicitados a generalizar, os modelos falhavam de maneira significativa.

Além disso, pequenas alterações nos dados de entrada, como mudanças no comprimento do texto, resultaram em quedas drásticas no desempenho. Os pesquisadores alertam que, embora o ajuste fino dos modelos possa melhorar resultados, isso não deve ser confundido com uma verdadeira capacidade de generalização.

Implicações e Preocupações

Essas limitações levantam preocupações em áreas críticas, como medicina e finanças, onde a precisão é vital. Em julho, um grupo de 30 pesquisadores de IA pediu mais investigações sobre as técnicas de monitoramento desses modelos, enfatizando a necessidade de garantir segurança e transparência nas operações de ferramentas avançadas de IA. A pesquisa destaca que, apesar de sua sofisticação, os modelos de CoT são, na verdade, imitadores de padrões, sem a capacidade de raciocínio complexo.

Perguntas Relacionadas

Comentários

Os comentários não representam a opinião do Portal Tela;

a responsabilidade é do autor da mensagem.